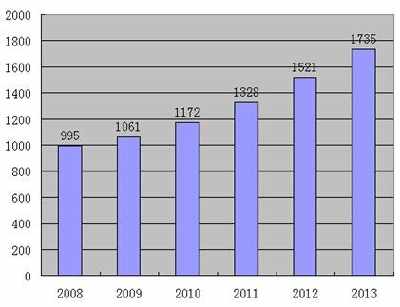

今天,我想介绍五篇关于ECCV 2020口述[图像识别]的相关论文,值得一读。ECCV、CVPR和ICCV被称为计算机视觉领域的三大会议。欧洲计算机视觉国际会议

2020年共提交5,025件,其中1,361件被受理,受理率为27%。

ECCV 2020年获奖论文名单地址:

https://eccv2020.eu/accepted-papers/

第1篇:自适应学习网络宽度与输入分辨率

论文:互网络:自适应convnet通过互学习网络宽度和。

分辨率”

下载地址:https://arxiv.org/abs/1909.12978.

https://github.com/taoyang1122/MutualNet

导读:深度神经网络在各种传感任务中取得了巨大的成功。然而,深度神经网络通常需要大量的计算资源,这使得它们难以部署在移动设备和嵌入式系统上。本文的贡献如下:

1.强调输入分辨率对于设计高效网络的重要性.以往的研究要么忽略它,要么将其从网络结构中分离出来。相比之下,本文将网络宽度和输入分辨率嵌入到统一的互学习框架中学习一个MutualNet,可以在运行时实现准确性和效率之间的自适应平衡。

2.进行了大量的实验证明,MutualNet的性能明显优于独立训练网络。

3.我们进行全面的消融研究,以分析提议的相互学习方案.我们进一步证明,我们的框架有望成为一种即插即用的策略来提高单个网络的性能,其性能大大超过了流行的性能改进方法,如数据扩展、SENet和知识蒸馏。

4.建议的架构是一个通用的训练计划,与模型无关.它可以应用于任何网络,无需任何结构调整。这使得它与其他最先进的技术兼容。比如神经结构搜索(NAS),自动数据增强技术。

提出了一种在动态资源约束(如每秒浮点运算)下训练网络的方法。该方法提出了一种输入分辨率和网络宽度相互学习的方案,可以在运行时达到自适应精度。

效率权衡的约束显著提高了轻量级网络在图像分类、目标检测和实例分割等各种任务中的准确性和效率权衡。在COCO目标检测、实例分割和迁移学习中也验证了该方法的优越性。令人惊讶的是,MutualNet的训练策略在效率方面也能提升单个网络的性能(GPU搜索时数:15,000)。

0)和准确性(ImageNet:77.6% vs 78.6%)比强大的自动数据增强技术要好得多。

这种相互学习方案也被证明是一种有效的训练策略,可以提高单个网络的性能。框架的普适性使其很好地转化为一个通用的问题域,也可以扩展到视频输入和3D神经网络,其时空信息可以被利用。

总体框架如下:

第2篇:基于随机特征采样和插值的空间自适应推理

论文:“随机特征采样和的空间自适应影响”。

插值>

下载地址:https://arxiv.org/pdf/2003.08866.pdf.

Github:尚未找到(欢迎添加消息)

引言:在卷积神经网络的特征映射中,存在大量的空间冗余和重复处理。为了减少这种冗余计算,本文提出了一种降低卷积网络计算复杂度的方法:只计算稀疏采样位置的特征,这些特征是根据激活响应概率选择的,然后使用有效的插值过程来重建具有密集集.的特征图

利用特征映射中固有的稀疏性和空间冗余性,我们避免了在能够有效执行插值的空间位置的昂贵计算。

框架图:

mg src='https://p26.toutiaoimg.com/large/pgc-image/c876ecb800b8425898cc16315fcc0650' alt='五篇值得阅读的ECCV 2020 图像识别相关论文' />第3篇:开放 集 识别的混合模型

论文题目:《Hybrid Models for Open Set Recognition》

下载地址: https://arxiv.org/abs/2003.12506

github:暂未发现(欢迎留言补充)

介绍:开放集识别需要一个分类器来检测不属于其训练集中任何类的样本,现有的方法对训练样本的嵌入空间上拟合一个概率分布,并根据这个分布来检测离群点。然而,这种分类只关注已知的类,对于区分未知的类可能没有什么效果。本文认为,表示空间应该由内层分类器和密度估计器(作为离群点检测器)共同学习。为此,提出了OpenHybrid框架,该框架由一个编码器将输入数据编码到一个联合嵌入空间,一个分类器将样本分类到一个内部类,以及一个基于流的密度估计器来检测样本是否属于未知类别。大量的实验表明我们的方法达到了最先进的水平。基于流的模型的一个常见问题是,它们通常为分布外的样本分配更大的可能性。通过学习一个联合特征空间,以及在不同的数据集上进行观察,这个问题得到了解决。研究还表明,联合训练是促进开放集的识别性能的另一个关键因素。

框架图:

第4篇:梯度集中(GC):一种新的深层神经网络优化技术

论文题目:《Gradient Centralization: A New Optimization Technique for Deep Neural

Networks》

下载地址: https://arxiv.org/abs/2004.01461

github: https://github.com/Yonghongwei/Gradient-Centralization

介绍:优化技术对于有效地训练深度神经网络(DNN)具有重要意义。与现有的基于激活度或权值的优化方法不同,本文提出了一种新的优化技术,即梯度集中(gradient

centralization,GC),它通过将梯度向量集中到零均值的方式,直接对梯度进行操作。通过综合实验表明,GC可以对权值空间和输出特征空间进行规整,可以很好地应用于不同优化器和网络架构下的不同任务,提高了训练效率和泛化性能。

框架图:

第5篇:多任务学习增强对抗鲁棒性

论文题目:《Multi-task Learning Increases Adversarial Robustness》

下载地址:https://arxiv.org/pdf/2007.07236.pdf

github:暂未发现(欢迎留言补充)

介绍:虽然深度网络在一系列计算机视觉基准上达到了很强的精确度,但它们仍然容易受到对手的攻击,一些无法察觉的干扰数据欺骗了网络。本文提供了理论和实证分析,将一个模型的对抗鲁棒性与它所训练的任务数量联系起来。在两个数据集上的实验表明,攻击模型的难度随着目标任务数量的增加而增加。此外,我们的结果表明,当模型在同时进行多任务训练时,它们在单个任务的对抗攻击中会变得更稳健。也就是说,训练任务数量低的情况下,模型更容易受到对手的攻击。我们的工作是第一次将这种脆弱性与多任务学习联系起来,并暗示了一个新的研究方向,以理解和减轻这种脆弱性。