李岩在演讲中表示,多模态技术有两大应用方向,一是改变人机交互方式,二是让信息分发更加高效;视频本身是一个多模态的问题,而Aauto faster拥有大量的多模态数据,因此多模态研究是Aauto faster非常重要的课题。目前,Aauto Quicker已经在语音识别与合成、智能视频配乐、2D图像驱动的3D建模效果、精准视频理解等领域开发应用了多模态技术。

以下是演讲的主要内容:

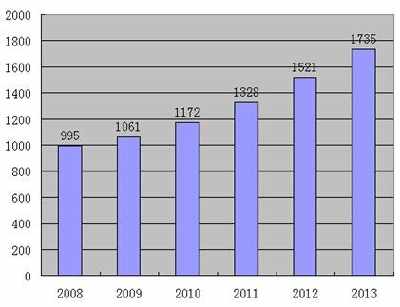

大家好,首先让我简单介绍一下Aauto faster。在这个平台上,用户可以看到广阔的世界,也可以看到广阔的世界。我们可以看看《自动加速》的数据:

视频总量70亿,新增视频1500万,日均使用时间超过60分钟等。所以在Aauto Quicker平台上有大量的多媒体数据和大量的用户交互数据。例如,我们有1.3亿用户每天观看超过150亿个视频。

我们知道视频是视觉、听觉和文本的多模态信息形式,用户的行为是另一模态的数据,所以视频本身就是一个多模态问题,而用户的行为是一个更复杂的多模态问题。因此,多模态研究是自动变速器的一个非常重要的课题。

# # #多模态技术的两大应用方向:人机交互和信息分发。

我认为多模态技术主要有两种应用。

首先,多模态技术将改变人机交互方式,我们与机器交互的方式将越来越接近更舒适自然的方式。

第二,多模态技术将使信息分发更加高效。

多模态技术研究的三大难点:语义鸿沟、异构鸿沟和数据缺失。

事实上,目前,多模态研究仍然非常困难。

其中,大多数人谈论语义鸿沟。虽然近十年来深度学习、大计算能力和大数据发展迅速,计算机视觉包括语音识别等技术也取得了长足的进步,但到目前为止,很多问题还没有得到特别好的解决,因此单一模式的语义鸿沟依然存在。

此外,由于各种模式信息的引入,如何对不同模式之间的数据进行综合建模将是一个异构的鸿沟问题。

此外,还有很多做语音和图像的数据集。你可以用这些数据集来复习和交流你的算法的研究成果。然而,多模态数据集很难构建,因此在进行多模态研究时会出现数据缺失的问题。

下面,我将分享我们在多模态这方面所做的工作,以及这些技术如何帮助Aauto Quicker平台获得更好的用户体验和反馈。

# # # #多模态技术如何实现更好的记录?

首先,多模态技术将实现更好的记录。随着智能手机的出现,每个人都可以使用手机上的摄像头记录周围的世界,并使用麦克风存储周围的音频信息。以前,制作视频,尤其是一些专业视频,是导演的工作。但是现在,我们可以通过手机来做,会有很多多模态的技术研究来帮助人们更好地记录。

希望整个录制过程更加便捷、个性化、有趣、包容。我将通过四个案例分享细节。

1、语音转文字打造便捷字幕生成体验

在视频中,音频部分对于整个视频的信息传输至关重要。网上有很多带很多字幕的视频,主要是讲述。其实制作这样的视频是一件很麻烦的事情,因为一个个的输入文字是很痛苦的。像过去一样,广播电视系统的专业工作室需要许多字幕编辑工具和软件。如果我们使用语音识别技术直接将语音转换成文本,就可以通过手机轻松编辑生成一段带字幕的视频。

2、语音合成实现个性化配音

另一种技术叫做个性化配音。如果你不喜欢听视频中的男性配音,而是想听女性配音,我们可以通过语音合成技术来满足个性化需求。

语音识别和合成技术会让我们的录音过程更加方便有趣,但这两项技术在做视觉或多媒体的圈子里并不是特别受关注,在做语音的圈子里也只是偶尔说说这些问题。包括语音圈,语音识别和合成往往是由两组人来完成的。

随着深度学习技术的出现,语音识别和合成在某种程度上是非常对称的,因为语音识别是从语音到文本,而语音合成是从文本到语音。在语音识别中,我们提取一些声学特征,通过编码器或Attention机制实现语音到文本的转换。事实上,语音合成的技术和算法也涉及编码器或Attention机制,它们形成了一个相对对称的网络。因此,我们把语音识别和合成作为模态转换的一个特例。

经网络建模角度来看,是一个比较一致、容易解决的问题。具体神经网络在设计的时候,虽然二者内容机制其实还是有一些不同,但更大的趋势是这里面将来会有更多的趋同,因为我们知道随着相关算法的发展,计算一定是朝着一个更加简化,更加统一的方向发展。就像深度学习的出现,其实就是通过计算的方式取代了手工来获取有效的特征。多模态的转换领域里面也出现了这样的特点,这是一件非常有意思的事情。

3、根据视频内容自动生成音乐

音乐也是短视频非常重要的一部分,有录视频经验的同学可以感受到,为一个场景配合适的音乐是一个很难的事情。过去,有不少用户为了与音乐节拍一致,努力配合音乐节奏拍摄,极大限制了拍摄的自由度。我们希望用户可以随意按照自己想要的节奏录制,所以让机器通过用户拍摄的视频内容,自动生成符合视频节奏的音乐,这样视频画面与音乐节奏就会更匹配、更一致。

音乐生成涉及很多具体的技术,我们也做了非常多的研究,其中一个问题是懂音乐的不懂计算机科学,懂计算机科学的人不懂音乐。想要把短视频配乐这个问题研究好,需要要有做音乐和做AI的人一起集成创新,这方面我们也做了非常多的工作。

4、2D图像驱动3D建模实现Animoji效果

通过苹果的发布会,大家应该都了解Animoji这项技术,iphoneX有一个标志性的功能,就是通过结构光摄像头实现

Animoji,现在国内手机厂商也越来越多地采用结构光的方式去实现Animoj。而快手是国内较早实现不使用结构光,只用RGB图像信息就实现Animoji效果的企业。

用户不必去花上万元去买iphoneX,只要用一个千元的安卓手机,就可在快手的产品上体验Animoji的特效,从而能够在不暴露脸部信息的同时展现细微的表情变化,例如微笑、单只眼睛睁单只眼睛闭等,让原来一些羞于表演自己才艺的人,也可以非常自如地表达。我们觉得做技术有一个非常快乐的事情,就是让原来少数人才能用的技术,变得更普惠。

其实解决这样一个问题是非常难的,因为即使是像苹果这样的公司,也是采用了结构光这样配置额外硬件的方式来解决。想让每一个用户都能享受到最尖端的技术,快手面临着硬件的约束,只能通过2D的RGB视觉信息对问题进行建模、求解,这里面包括了像Landmark人脸关键点检测、实时重建人脸三维模型等技术,把2D和3D两种不同模态的信息做建模、做对齐。

我们也能看到现在市场上可能有一些小型的APP在做类似的事情,但体验很差,而我们的整体体验还是非常好非常流畅的,这也需要归功于深度神经网络模型的量化,通过压缩和加速解决手机性能问题,可适配任意机型。

### 多模态技术如何实现精准理解视频内容

刚才我讲的是我们多模态技术怎样去帮助用户更好地记录,我们同时也希望通过一个更好的分享机制,让用户发布的视频能够被更多感兴趣的人看到。这也涉及视频推荐里面多模态的一些问题。

对视频内容的理解其实是非常难的,这个里面我做了两个比较有意思的事情。

第一,我们强调音频和视觉的多模态综合的建模,而不是仅仅是单独的视觉或者音频,视觉和听觉两种媒体的融合,会是未来一个非常重要的事情。

第二,在工业界做的事情和在学术界做的事情有很大不同,我们有非常多的用户数据,这些用户数据是不在传统多媒体内容研究范畴里面的,但是工业界可以很好地利用这些数据,更好地做内容理解。

给大家举个例子,一个男子表演口技的视频中,如果关闭声音,仅凭画面信息,我们并不知道他是在做什么,可能会觉得是在唱歌或唱戏。这说明如果仅仅是通过视觉的话,你可能无法获得真实的信息。我们对世界的理解一定是多模态的理解,而不仅仅是视觉的理解。

像这样的视频在快手数据库中有70亿,想要理解这么多的视频内容,必须借助多模态技术。所以我们在这方面也做了非常多的工作,从文本、视觉、听觉角度去做了很多单模态的建模,包括多模态的综合建模、有序与无序,以及多模态特征之间怎样进行异构的建联,在很多任务内部的分类上也做了改进。

第二点需要强调的是,像ImageNET等很多的学术界研究内容理解的任务有非常好的标注数据集,但是这个数据集对于工业界来说还是太小,且多样性不够。我们平台每天有1.3亿多用户以及超过150亿次的视频播放,这个数据是非常大的。如果有150亿的标注数据,做算法就会有很大的帮助,但是现实上是不具备的。

那怎样将研究分析技术与海量数据更好地做到两者的融合呢?我们通过融合行为数据和内容数据,进行综合建模,同样大小的人工标注量,利用海量的用户行为数据,能够获得比纯内容模型更好的性能,对视频有了一个更好的理解,进而在多媒体内容的理解和分析方面的算法研究有了非常大的进展,这就使我们在工业界和传统学术界做这个事情时会更有优势。

### 未来多模态研究的热点:特征表达与特征对齐

总结一下,多模态内容解决的问题里面涉及一些模态的转化,比如怎样通过2D图像驱动3D,怎样通过语音生成文本或者通过文本生成语音,怎样通过视觉驱动音乐。另外一个应用是我们怎样通过融合更多信息来驱动内容的理解,其实都是一个多模态的问题。在学术界有很多研究还是停留在单模态,但我个人认为未来多模态会成为更有价值的研究方向。

多模态研究会有两个难点或者说热点:

第一是多模态的特征表达,也就是在多模态研究框架下怎样设计单模态的特征,这是一个非常重要的问题。

第二是多模态特征之间如何对齐,也就是有没有更好的算法对视觉、听觉和行为的部分进行统一的建模,这是未来的一个热点。

### 几个总结

第一,多模态未来会持续带来更新的人机交互方式,比如我们刚才讲的Animoji技术,其实它带来的是一种可以通过人脸控制手机自动生成Avatar(虚拟动画)的体验。原来实现这些效果,需要在好莱坞专门设一个特效室来实现这一点,而现在普通用户都能享受这样的技术,所以人机交互会由原来重的、贵的、笨的方式转变为便宜的、每个人都能参与的而且便捷的方式。

第二,我认为多模态技术会带来新的内容形态,原来接入信息更多是从文本、页面中获得,现在有视频,未来可能还会有AR或者其它的形式。我觉得多模态AR很重要的一点就是强调沉浸感,这种沉浸感其实是通过听觉和视觉综合作用才能产生的。

第三,我认为多模态亟需新的算法和大型的数据,因为这两者可能会是一个某种意义上可以相互折算的问题。以目前的机器学习算法来讲,需要海量的数据才能解决好这个问题,因为现在深度学习、内容理解的成果,某种意义上是监督学习的成果,有足够的样本、算力,所以现在的算法能力基本上还停留在对算力和数据有着非常大要求的阶段。而多模态的大型数据是非常难建的,而且多模态解的空间是更大的。因为一个模态解的空间是n,另外一个是m,它最后是一个乘积、一个指数级的变化,所以数据集要多大才足够是一个很难的这个问题,可能需要新的算法来对这个问题进行建模。

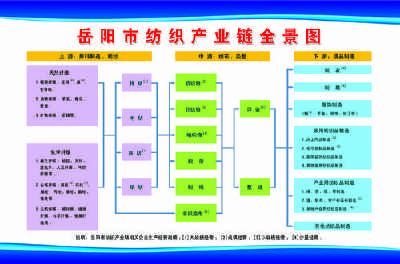

### 关于快手多媒体内容理解部门

快手多媒体内容理解部门(Multimedia Understanding)简称MMU

,团队由近百名算法工程师、应用工程师构成,聚焦多媒体内容的理解与应用。在内容理解方面,MMU主要通过对人脸、图像、音乐、视频四个维度实现对多媒体内容的感知,并融合感知内容和知识图谱,实现对视频高层语义及情感的理解,从而让机器高效看懂海量内容。目前,多媒体内容理解部的核心技术服务于内容安全、原创保护、视频创作、视频推荐、视频搜索及商业化等方面。